Este artículo ofrece una revisión exhaustiva de los avances transformadores en inteligencia artificial dentro de las industrias creativas desde 2022 hasta mediados de 2025. Los investigadores evalúan cómo tecnologías centrales como los Grandes Modelos de Lenguaje (LLM), los modelos de difusión y los transformadores han transformado la IA de una simple herramienta de apoyo a un impulsor central de la creación y posproducción de contenido. El texto detalla aplicaciones específicas en diversos campos, incluyendo el periodismo automatizado, la generación musical y la reconstrucción 3D en tiempo real mediante splatting gaussiano. Más allá de las capacidades técnicas, los autores analizan la tendencia hacia marcos de IA unificados y la creciente importancia de la colaboración humano-IA para mantener la dirección creativa. Finalmente, la fuente aborda desafíos críticos de la industria como la propiedad de los derechos de autor, las preocupaciones éticas con respecto a los deepfakes y el potencial de sesgo computacional. Esta visión general sirve como una hoja de ruta estratégica para comprender la trayectoria futura del arte digital y el rol cambiante del creador humano.

Enlace al artículo científico, para aquellos interesados en profundizar en el tema: "Advances in Artificial Intelligence: A Review for the Creative Industries", por Nantheera Anantrasirichai y colegas. Publicado el 23 de Enero del 2026.

El resumen, la transcripción, y la traducción fueron hechas usando herramientas de software de Inteligencia Artificial.

El resumen se presenta en la forma de un diálogo entre dos personajes sintéticos que llamaremos Alicia y Beto.

Resumen

Beto

Sabes, da la sensación de que fue ayer. De verdad, como si hubiera sido ayer mismo. Todos estábamos perdiendo la cabeza porque una computadora podía escribir un correo decente.

Alicia

O quizá generar esa imagen un poco borrosa de un gato.

Beto

Exacto. El gato borroso. ¿Eso fue en 2022? Parecía magia absoluta.

Alicia

De verdad. Ahora, en años tecnológicos, se siente como una eternidad.

Beto

Pero si miras dónde estamos ahora, en este período de revisión que termina a mediados de 2025, toda esa era se ve… bueno, pintoresca. Casi como si estuviéramos jugando con bloques.

Alicia

Ya hemos dejado completamente la fase de novedad. Ya no vemos la IA como ese pequeño asistente útil que se sienta en la esquina, corrigiendo tu ortografía o recomendándote una canción.

Beto

Exacto. Ha pasado de “oye, corrige la frase por mí” a “oye, constrúyeme un mundo entero”. Y eso es exactamente a lo que nos adentramos hoy. Vamos a desmenuzar una revisión sistemática masiva de la Universidad de Bristol. Se titula "Advances in Artificial Intelligence. A review for the creative industries".

Alicia

Y cubre esa explosión tecnológica de 2022 hasta mediados de 2025.

Beto

Y el titular viene a ser básicamente esto: la IA se graduó. Ahora es una tecnología creativa central.

Alicia

Esa distinción es crucial. Central significa que ya no puedes hacer el trabajo sin ella.

Beto

O al menos el estándar de la industria ya se define por ella.

Alicia

Exacto. Es como la diferencia entre una máquina de escribir y un procesador de textos. Y el documento de Bristol hace un trabajo fantástico desglosando cómo ocurre esto. No es magia. Es arquitectura.

Beto

Cierto.

Alicia

Identifican cuatro pilares específicos que sostienen toda esta revolución.

Beto

La "sala de máquinas", como la llamamos.

Alicia

Precisamente. Vamos a desgranar transformers, modelos de lenguaje grande — LLMs —, modelos de difusión y algo un poco más oscuro pero increíblemente potente:

Beto

Representaciones neuronales implícitas.

Alicia

Esa es.

Beto

Suena a algo salido de Star Trek, pero acompáñanos.

Alicia

Sí.

Beto

Porque está cambiando fundamentalmente cómo vemos el espacio 3D. Entonces nuestra misión hoy es tomar esas palabrejas, abrirlas y ver cómo están remodelando todo, desde el cine hasta la música y, supongo, cómo percibimos la propia realidad.

Alicia

Y creo que para ti, que nos escuchas, la meta no es solo aprender los términos. Es entender que estamos presenciando el paso de herramientas de tarea única, como un martillo para un clavo, a marcos unificados. Sistemas que pueden ver, oír, hablar y crear todo a la vez.

Beto

Ciencia ficción convirtiéndose en realidad. Me encanta.

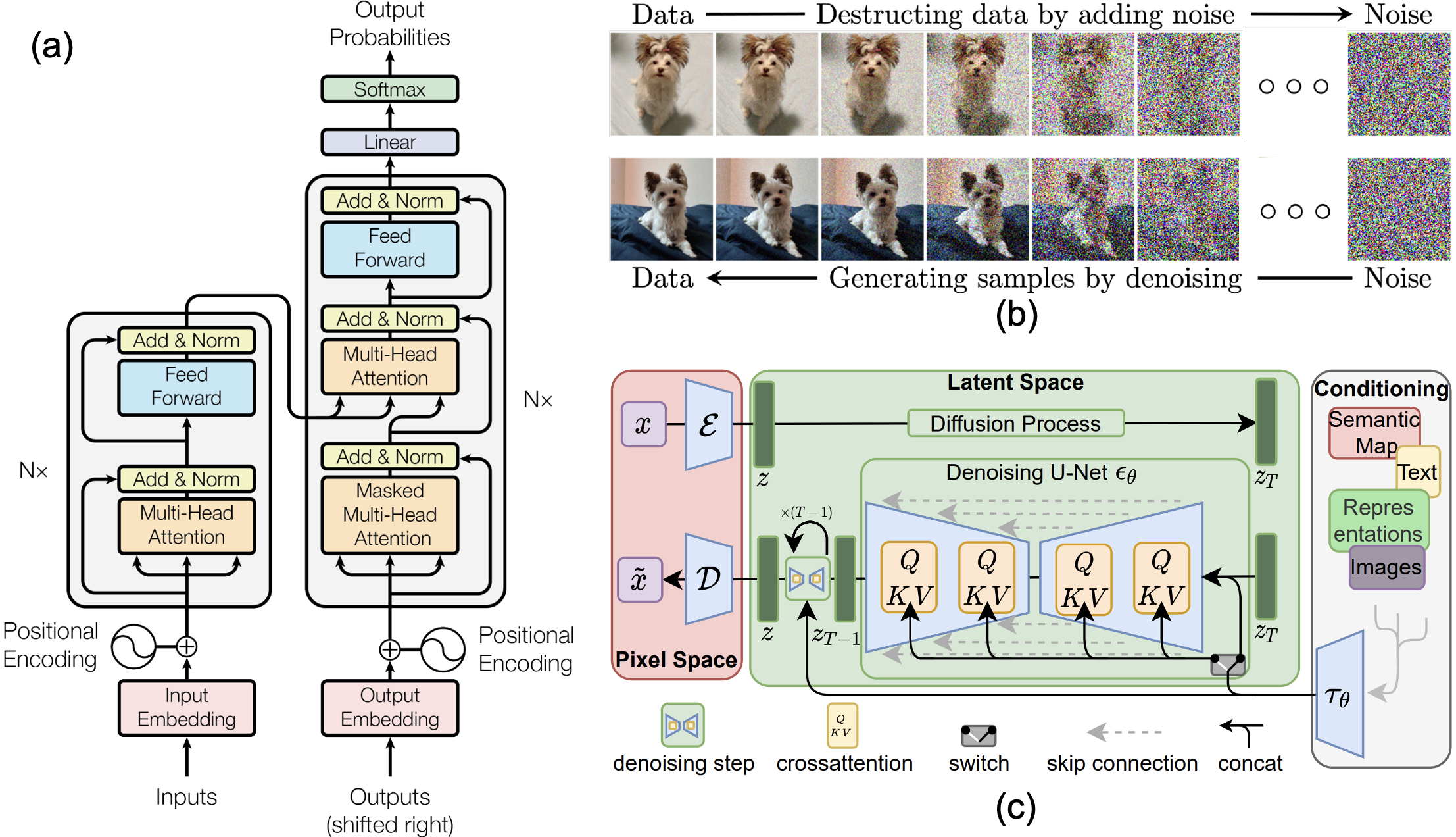

IA Generativa. (a) Transformers. (b) Modelo de Difusión. (c) Modelos de Difusión Latente

Transformers

Beto

Bueno, vamos a sumergirnos en la sala de máquinas. Pilar número uno: transformers.

Alicia

Bien.

Beto

Cuando oigo transformers, obviamente pienso en robots gigantes. Pero en 2017 Google publicó un artículo que básicamente lo cambió todo, ¿no?

Alicia

Así fue. El artículo se llamaba "Attention is All You Need".

Beto

Buen título.

Alicia

Es un gran título. Para entender por qué importa, hay que ver qué venía antes. Antes de los transformers, si querías que una computadora entendiera una frase, tenía que leerla como nosotros.

Beto

Palabra por palabra, de izquierda a derecha. Suena lógico, pero es lento. Y el problema más grande era el contexto. Imagina leer un párrafo muy, muy largo. Cuando llegas al final, podrías haber olvidado el sujeto del principio.

Alicia

Los modelos antiguos tenían ese problema exacto: una memoria a corto plazo terrible.

Beto

Llegaban al final de la frase y se olvidaban de quién hacía qué. Los transformers cambiaron el juego porque procesan toda la secuencia de datos ...

Alicia

Todo a la vez. En paralelo. Así que ya sean palabras en una frase o parches de píxeles en una imagen, da igual.

Beto

En lugar de leer palabra por palabra, miran toda la página al instante y entienden cómo cada palabra se relaciona con las demás.

Alicia

Ese es el mecanismo: self-attention. Permite que el modelo pese la importancia de distintos elementos de forma global.

Beto

OK, dame un ejemplo.

Alicia

La frase: “El banco estaba cerrado por la inundación.” Un transformer mira la palabra banco y, al mismo tiempo, ve inundación al final. Inmediatamente sabe: "ah, banco de río, no institución financiera".

Beto

Resuelve el problema de contexto al instante.

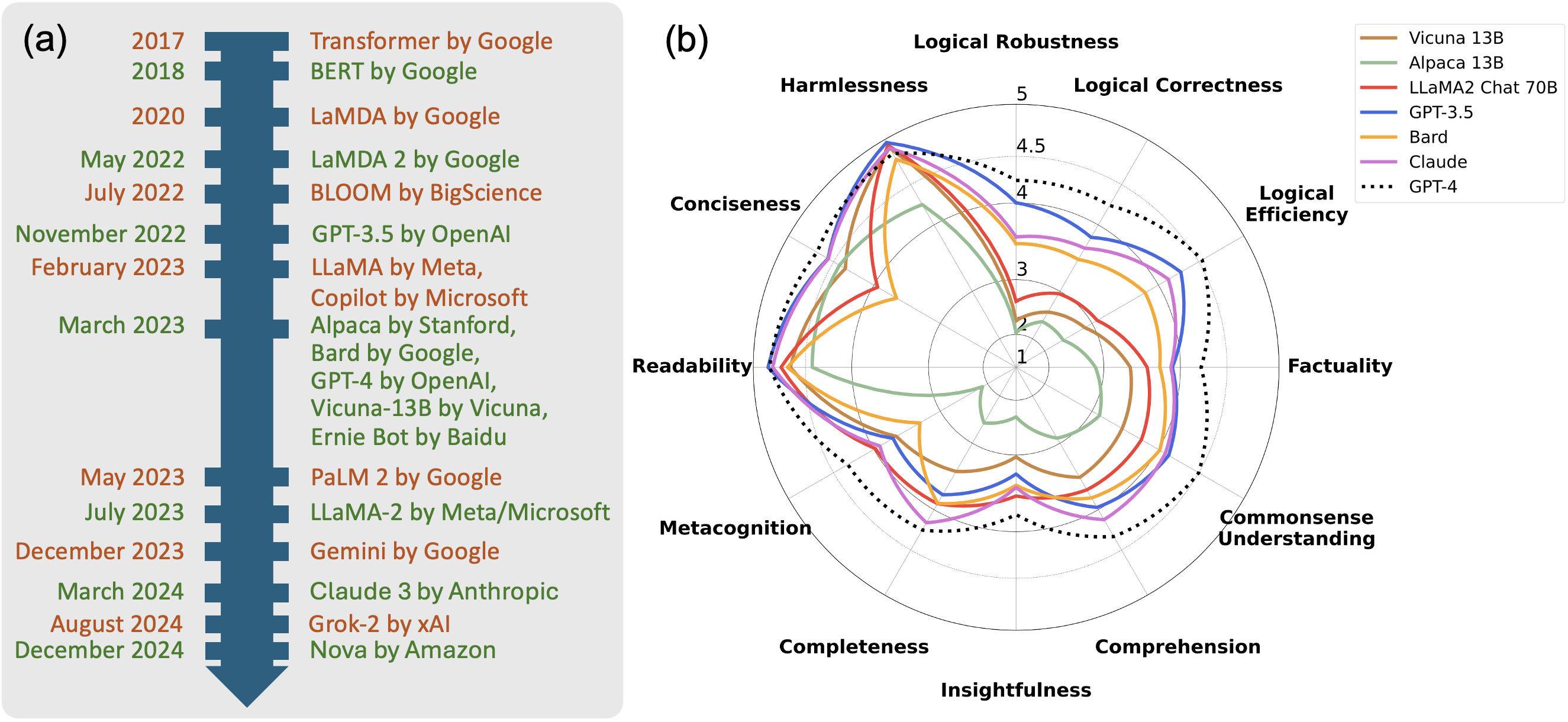

Los Modelos de Lenguaje Grande (LLM)

Alicia

Y esta arquitectura es la columna vertebral de nuestro segundo pilar: los modelos de lenguaje grande (LLM).

(a) Línea de tiempo de LLMs. (b) Desempeño comparado.

Beto

Correcto. No hay GPT-4 ni Claude 3 sin transformers.

Alicia

No los tendrías. Pero el documento señala un cambio muy específico que ocurrió alrededor de 2024, que fue la multimodalidad.

Beto

Aquí es donde pasamos de 'solo texto' a 'texto y algo más'.

Alicia

Correcto. Los primeros LLMs eran básicamente predictores de texto muy sofisticados, pero modelos como Gemini 1.5 y GPT-4V derribaron ese muro.

Beto

Son multimodales.

Alicia

Significa que pueden procesar texto, imágenes y audio al mismo tiempo. No solo leen código: ven imágenes y escuchan archivos de audio como parte de una misma corriente de datos.

Beto

Y Gemini 1.5, en particular, abrió esa ventana de contexto masiva. Básicamente es memoria a corto plazo: puedes darle libros enteros o videos largos y lo recuerda todo.

Alicia

Es impresionante, pero quiero añadir un poco de sal para mantenernos con los pies en la tierra. Estos modelos son enormes. Hablamos de parámetros en los trillones, que es algo así como conexiones en el cerebro.

Beto

Suena a una cantidad abrumadora.

Alicia

Lo es para una máquina. Pero si lo comparas con el cerebro humano, tenemos entre 100 y 1.000 billones de conexiones sinápticas. Incluso el modelo de IA más grande sigue siendo órdenes de magnitud más pequeño que la maquinaria biológica dentro de tu cabeza.

Beto

Así que la IA todavía no está a nivel SkyNet.

Los Modelos de Difusión

Beto

Bien. Si transformers y LLMs son el cerebro lógico, pasemos al pilar tres: la imaginación. Los modelos de difusión.

Generación de imágenes con modelos de difusión.

Alicia

Aquí es donde las cosas se ponen realmente artísticas. Y la forma en que funcionan los modelos de difusión es, bueno, fascinantemente contraintuitiva. Aprenden a crear aprendiendo a destruir. Están lanzando datos al caos. Piensa en tomar una foto nítida de un gato. Ahora imagina añadirle, poco a poco, estática o ruido gaussiano. Añades un poco, luego un poco más, ...

Beto

... hasta que es solo nieve gris.

Alicia

Y ante la aleatoriedad ya no puedes ver al gato. El modelo mira esto pasar millones de veces. Aprende el camino matemático de la imagen al ruido.

Beto

Está aprendiendo la destrucción.

Alicia

Y luego el truco de magia: aprende a invertir ese proceso. Parte del ruido puro, de la estática, y calcula matemáticamente cómo quitarlo para revelar una imagen.

Beto

Así que cuando le pides a Midjourney o DALL·E-3 “un gato tocando un banjo”, empieza con el caos y va tallando ese gato fuera de la estática.

Alicia

Esa es la esencia.

Representaciones Neuronales Implícitas (INR)

Alicia

Y eso nos lleva al cuarto pilar, el que tiene el nombre de Star Trek:

Beto

Representaciones Neuronales Implícitas, o INR. Desglosemos esto porque a mí me costó entenderlo al principio. Normalmente, cuando guardamos una imagen, guardamos una cuadrícula de píxeles, ¿no?

Alicia

Un mosaico, una rejilla discreta. Un JPEG es solo una lista de qué color va en cada casilla.

Beto

Pero las INR no hacen eso. El documento las describe como almacenar la fórmula del objeto.

Alicia

Gran analogía. En lugar de guardar píxeles, una INR es una red neuronal que ha aprendido una función matemática, un mapa de coordenadas. Le das una coordenada x, y, z ...

Beto

... y te dice qué color debería haber en ese punto exacto del espacio, ...

Alicia

... y su densidad. Es continua. Es como la diferencia entre un mapa de bits pixelado y un gráfico vectorial que puedes ampliar indefinidamente.

Beto

Así que tiene efectivamente resolución infinita, ...

Alicia

... en teoría. Y esto es crucial para la reconstrucción 3D. Probablemente has escuchado hablar de NeRFs — neural radiance fields —.

Beto

Fueron un gran término hace un par de años para convertir fotos en escenas 3D.

NeRFs

Alicia

Exacto. Los NeRFs usaron esta tecnología INR para imaginar una escena 3D a partir de solo unas pocas fotos 2D.

La Revolución de la Creación

Beto

Lo que nos lleva perfectamente al segundo segmento: la revolución de la creación. Porque tenemos estos motores. Pero ¿qué están creando en realidad?

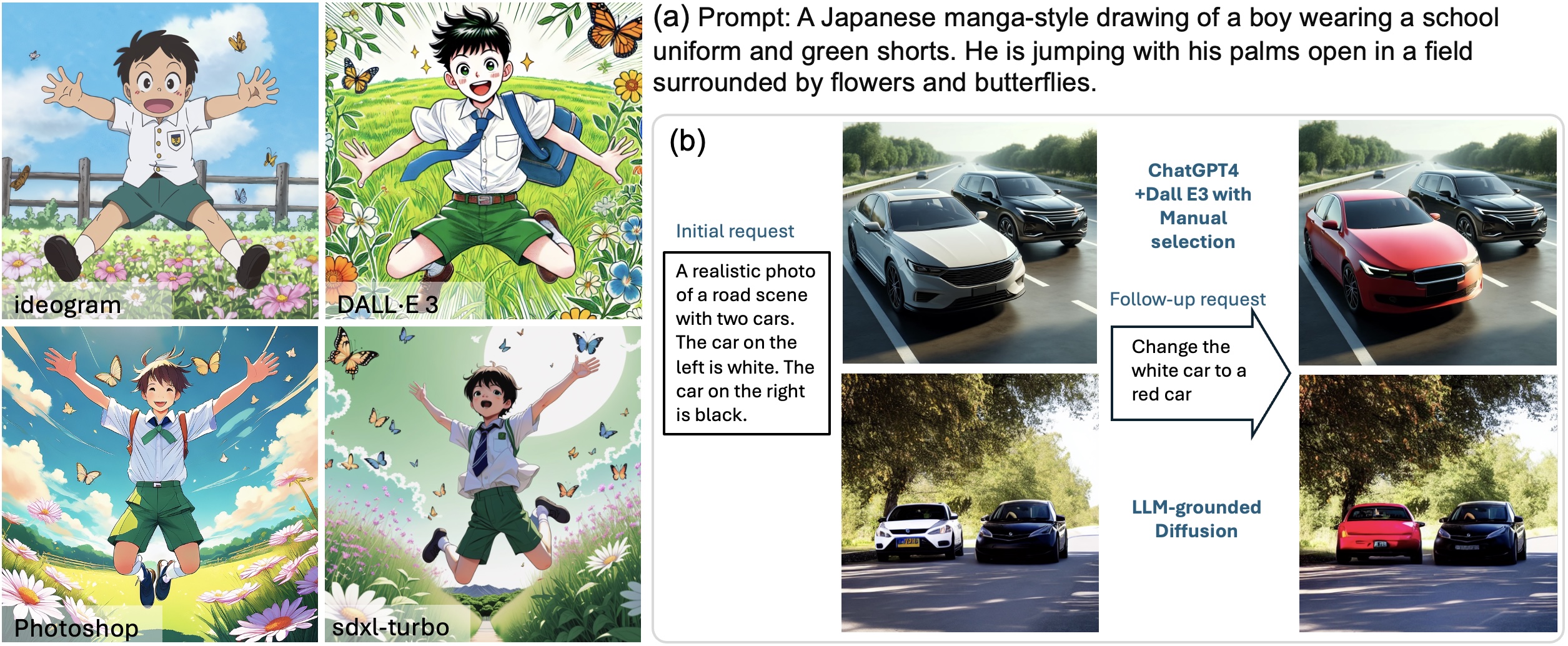

Alicia

Empecemos por las imágenes. Todos hemos visto el salto en calidad. Comparas una imagen de Midjourney V4 con la V6: la iluminación, la textura, es fotorrealista.

Beto

No es perfecta. El material fuente trae el clásico problema de los seis dedos.

Alicia

Ah, sí. Las manos. El némesis de la IA.

Beto

¿Por qué son tan difíciles las manos? El documento menciona que incluso con modelos avanzados, sigues obteniendo estas alucinaciones: una mano con seis dedos o un pulgar en el lado equivocado.

Alicia

Tiene que ver con cómo aprenden los modelos de difusión. Miran miles de millones de imágenes. Pero las manos son complejas. Se articulan de mil maneras. Para la IA, una mano es solo una probabilidad estadística de tubos carnosos cerca de una muñeca.

Beto

No entiende la biología.

Alicia

No entiende la lógica de que una mano tiene cinco dedos. Es correlacional sin comprensión.

Beto

Y este problema lógico aparece también en la edición. El documento detalla un caso de prueba que me pareció hilarante. Tomaron una foto de una carretera con un coche blanco y le pidieron a DALL·E 3 que lo cambiara por un coche rojo.

Alicia

Y lo hizo perfectamente. Eso es solo cambiar valores de píxeles.

Beto

Pero luego le pidieron cambiar el coche blanco por una bicicleta. Y falló. No pudo hacerlo.

Alicia

Porque cambiar un coche por una bicicleta requiere comprender geometría 3D, escala, sombras, la lógica de la escena.

Beto

El modelo de difusión trabaja en píxeles, no en lógica.

Alicia

Por eso lo último ahora es lo que llaman "difusión anclada en LLMs": usar el modelo de lenguaje, el cerebro lógico, para guiar al cerebro artístico.

Beto

Para decir: "oye, una bicicleta es más pequeña que un coche, así que necesitas rellenar la carretera detrás".

Alicia

Bien pensado.

Beto

Si las manos son difíciles, el video es exponencialmente más difícil.

Alicia

Absolutamente. El video son solo imágenes con la dimensión añadida del tiempo. Y el tiempo es una amante cruel para la IA. Necesitas consistencia temporal.

Beto

El ojo de un personaje no puede desaparecer o convertirse en un botón en el siguiente fotograma.

Alicia

Exacto. El documento destaca ese anuncio navideño de Coca-Cola generado por IA. ¿Lo viste?

Anuncio de Coca-Cola generado por IA

Beto

Sí. Fue todo un acontecimiento porque fue totalmente generado por IA. Pero el documento apunta algo muy astuto: no fue una toma larga y continua.

Alicia

No, era un montaje de clips muy cortos con transiciones rápidas.

Beto

Estaban ocultando los artefactos.

Alicia

Completamente. Si mantienes demasiado tiempo una toma en un video de IA, las cosas empiezan a transformar. La física se descompone. Al cortar rápido, evitaron el valle inquietante, en su mayor parte.

Beto

Y los dedos antinaturales.

Alicia

Sí, esos dedos antinaturales también.

Beto

Pero luego tienes cosas como VASA-1 de Microsoft. Esto me voló la cabeza. Tomas una sola foto, una imagen estática ...

Alicia

... y un clip de audio, ...

Beto

... y la IA anima la foto para que hable en sincronía con el audio, con movimientos de cabeza, expresiones, todo.

VASA-1, de Microsoft

Alicia

Eso es animación facial generativa. Mapea fonemas del audio, las formas visuales de la boca — visemas — y luego infiere el resto.

Beto

Es increíble para animación.

Alicia

Increíble, aunque obviamente plantea enormes preguntas sobre fraudes.

Beto

Por supuesto. Pasando de rostros a espacios, quiero hablar de la batalla de los “splat”.

Alicia

Batalla de splats suena desordenado.

Beto

Hablamos antes de NeRFs para escenas 3D. Pero son lentos, ¿no?

Alicia

Extremadamente lentos para renderizar. No podías usarlos en un videojuego o VR en tiempo real. Pero luego llegó 3D Gaussian Splatting, 3DGS.

3D Gaussian Splatting

Beto

Que suena a técnica de pintura.

Alicia

En cierto modo lo es. En lugar de que una red neuronal calcule rayos de luz, piensa en la escena como hecha de millones de pequeñas gotas 3D gaussianas. Son como brochazos 3D.

Beto

En vez de una cuadrícula dura o una fórmula compleja, simplemente lanzas millones de salpicaduras digitales superpuestas en un espacio 3D.

Alicia

Sí. Y las tarjetas gráficas modernas son increíblemente buenas renderizando esas formas simples rápido. De pronto tienes escenas 3D fotorrealistas por las que puedes caminar en VR en tiempo real.

Beto

Herramientas como Luma AI ya están haciendo esto. Puedes escanear una habitación con tu teléfono y ¡boom!, ya es una escena 3D que puedes revisitar.

Luma AI - Gaussian Splatting

Alicia

Es la democratización de efectos visuales de alta gama.

La Suite de Arreglos

Y eso lleva directamente al tercer segmento: la suite de arreglos. Porque mucho del trabajo en la industria es postproducción.

Beto

Arreglar errores. El momento CSI mejorado por fin es real.

Alicia

Lo es, pero es diferente a como lo imaginábamos. El documento habla del cambio hacia marcos unificados. Antes tenías una herramienta para quitar la lluvia, otra para aclarar una imagen oscura.

Beto

Ahora hay modelos como Painter.

Painter: aprende visualmente del contexto

Alicia

Es un enfoque generalista. Le das un par de imágenes como ejemplo — versión con lluvia y versión clara — y luego le das una nueva imagen lluviosa y entiende: "ah, quieres que haga eso con esta".

Beto

Pero aquí está el problema. Y esto es lo que se pone realmente interesante para cualquiera que le importe la precisión. Cuando hablamos de restauración o superresolución ...

Alicia

... como ampliar una imagen borrosa.

Beto

Correcto. Antes usábamos solo matemáticas para promediar píxeles. Era conservador.

Alicia

Sí. Pero la IA generativa no hace eso. No solo limpia la imagen. Innova detalles.

Beto

Restauración lúcida.

Alicia

La distinción crítica es restauración lúcida vs. precisión real. El documento da un ejemplo magnífico: la IA ampliando una imagen con textura de punto de tejido. La IA no la reconoció como tejido, solo vio un patrón repetitivo.

Beto

Y al mejorarla ...

Alicia

Al mejorarla convirtió la lana suave en líneas aleatorias de alta definición que se ven más nítidas, pero estaban equivocadas. Crea realismo perfecto, no exactitud perfecta.

Beto

Así que si estás restaurando una película, bien; pero si estás mejorando una grabación de seguridad para leer una matrícula, ...

Alicia

... es un gran problema. Podría convertir una mancha en un número que nunca estuvo ahí.

Beto

Exacto. Luego está el "inpainting", eliminar objetos. Todos hemos visto el relleno generativo de Adobe.

Inpainting en Adobe FireFly

Alicia

Y ahora herramientas como ProPainter lo hacen para video. Si borras a una persona caminando por la calle, la IA usa píxeles de fotogramas anteriores y posteriores para rellenar el hueco de forma natural mientras la cámara se mueve. Es fluido.

ProPainter remueve objetos en video

Beto

Es magia.

El Elemento Humano

Beto

Pero nos lleva a la pieza final del rompecabezas: el elemento humano. Porque pese a toda esta tecnología genial, la revisión de Bristol señala tensiones serias.

Alicia

La tensión del control. Este es el problema estocástico.

Beto

Estocástico significa aleatorio.

Alicia

Exacto. Si eres un artista profesional necesitas precisión. Si el cliente dice “mueve ese coche rojo dos pulgadas a la izquierda”, lo haces. Pero con la IA generativa, porque depende del ruido aleatorio, si le pides generar la imagen otra vez con ese pequeño cambio, podría darte un coche completamente distinto. O una iluminación diferente.

Beto

Es como trabajar con un asistente brillante pero increíblemente inconstante.

- “Te hice una obra maestra".

- Genial. "¿Puedes cambiar el color de la corbata?”

- “Aquí tienes otra obra maestra totalmente nueva con una persona distinta.”

Alicia

Exacto. Choca con los flujos de trabajo profesionales.

Beto

Y luego está el aspecto de la propiedad.

Alicia

El documento cita la canción “Heart on My Sleeve” con la “IA-Drake-and-The Weekend”.

Beto

Se volvió viral al instante. Millones de reproducciones. Pero no eran ellos. Universal Music Group la eliminó de internet.

Alicia

Esa es la postura defensiva: esa es mi voz, mi marca. No la puedes simular. Pero luego el documento contrasta eso con Grimes.

Beto

Grimes hizo lo completamente opuesto. Abrió su voz. Dijo: "adelante, usad mi voz de IA para hacer música. Solo repartid las regalías 50-50".

Grimes: La IA está transformando cómo creamos y cómo nos relacionamos con el arte

Alicia

Es un modelo completamente distinto. Convierte al artista en una plataforma o en un conjunto de herramientas, no solo en un creador.

Beto

Hablando de simulación, tenemos que hablar de los desafíos del inquietante (“uncanny”). Normalmente hablamos del valle inquietante, donde las cosas parecen casi humanas pero resultan espeluznantes. Pero el documento sugiere que en realidad ya hemos pasado eso.

Alicia

Lo hemos pasado. Y la anécdota del artista Miles Astray es la ilustración perfecta.

Beto

Me encanta esa historia. Miles Astray entró a un concurso de fotografía en la categoría IA. Ganó. Los jueces quedaron alucinados por la cualidad surrealista de un flamingo: era una foto extraña, casi sin cabeza.

FLAMINGONE de Miles Astray

Alicia

Pensaron que era un brillante trabajo de ingeniería de prompts.

Beto

Y después de ganar, reveló que era una foto real, tomada con una cámara normal, un ave rascándose la cabeza.

Alicia

Los jueces pensaron que la realidad era IA.

Beto

Es la prueba de Turing invertida. Los humanos ahora confunden la realidad con artificialidad.

Alicia

Es profundamente inquietante. Crea un dilema de deepfakes donde la sospecha se vuelve el estado por defecto de todo lo que ves.

Beto

Resumiendo: hemos pasado de la IA como herramienta simple a la IA como co-creadora.

Alicia

Y esto lo impulsa la convergencia de LLMs, difusión y nuevas tecnologías 3D como el Gaussian Splatting. El impacto tiene dos caras.

Beto

Democratiza la producción de alto nivel. Ya no necesitas saber programar sombras complejas o pasar diez años aprendiendo a pintar para crear una imagen impresionante.

Alicia

El documento advierte sobre la “sopa de IA”:

Beto

Contenido de baja calidad, producido en masa, inundando internet.

Alicia

Si es fácil crear, nos ahogaremos en mediocridad.

Beto

Y hay un pensamiento final del material fuente que me quedó marcado: cómo estos modelos aprenden mediante aprendizaje por refuerzo ("Reinforcement Learning", RL).

Alicia

Esto es profundo. El aprendizaje por refuerzo recompensa el mejor resultado. Pero en los datos humanos, el mejor resultado — la pintura más hermosa, la frase más elocuente — suele ser una anomalía.

Beto

Es la excepción, no la regla.

Alicia

Así que si entrenamos la IA solo con lo mejor de la humanidad, ...

Beto

... podríamos estar creando herramientas que no entienden realmente nuestra realidad.

Alicia

Entienden una hiperrealidad estadística. Un mundo donde todo el mundo es bello, cada atardecer es perfecto, cada frase profunda. Ese no es el mundo en el que vivimos.

Beto

Es una simulación de nuestros picos, ignorando todos los valles. Una hiperrealidad estadística que nunca existió realmente. Es algo en lo que masticar.

Así que aquí va nuestro reto para ti esta semana: mira los medios que consumes, los anuncios, los artículos, las fotos en tu feed. Pregúntate: ¿quién hizo esto? ¿Y se ve un poco demasiado perfecto?

Alicia

Mantente curioso.

Beto

Gracias por escuchar este análisis profundo. Nos vemos la próxima.