Este artículo científico me llamó la atención porque hace referencia a lo que la gente creativa hace con el arte digital. Sin embargo, hay que tener en cuenta que fue publicado en el 2021, y desde entonces han salido tecnologías mucho más avanzadas, que discutiremos en otros artículos en un futuro próximo.

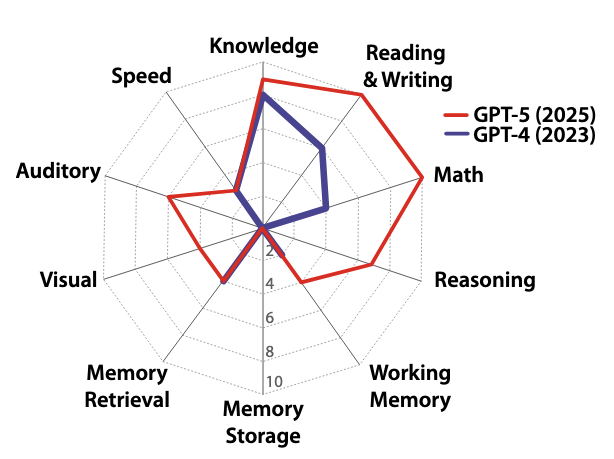

Las artes computacionales modernas han evolucionado desde la simple digitalización hasta un ecosistema colaborativo donde la inteligencia artificial y la realidad extendida impulsan activamente el proceso creativo. Este cambio es fundamental para el metaverso emergente, un vasto panorama virtual donde los tokens no fungibles (NFT) proporcionan un marco descentralizado para establecer la propiedad digital y comercializar activos virtuales. Innovaciones como la IA generativa para poesía y caligrafía, los artistas robóticos y las simulaciones cinematográficas están redefiniendo los límites artísticos tradicionales. Además, la realidad virtual y los motores de juegos democratizan la creación de contenido, permitiendo a las personas diseñar experiencias inmersivas y participar en conciertos virtuales globales. A pesar de estos avances, el campo enfrenta obstáculos significativos con respecto a la privacidad digital, el impacto ambiental de la tecnología blockchain y la necesidad de retroalimentación háptica para simular sensaciones artísticas físicas. En última instancia, la integración de estas tecnologías sugiere un futuro donde cada participante puede convertirse en un creador digital dentro de un mundo compartido e interactivo.

Enlace al artículo, para aquellos interesados en profundizar en el tema: "When Creators Meet the Metaverse: A Survey on Computational Arts", por Lik-Hang Lee y colegas. Publicado en Noviembre 26 del 2021.

El resumen, la transcripción, y la traducción fueron hechas usando herramientas de software de Inteligencia Artificial.

El resumen se presenta en la forma de un diálogo entre dos personajes sintéticos que llamaremos Alicia y Beto.

Resumen

Beto

Bienvenidos a un nuevo análisis profundo. Hoy nos ponemos el sombrero de arquitectos digitales. Vamos a explorar uno de los lienzos más emocionantes — y supongo que caóticos — que el mundo moderno haya visto: las artes computacionales dentro del metaverso en explosión.

Alicia

Realmente es un lienzo definido por su escala. Y el metaverso, tal como lo vemos, no es solo un mundo virtual. Es este enorme ciberespacio en constante evolución donde la creatividad digital y nuestro mundo físico real empiezan a fusionarse.

Beto

Creando un espacio masivo de oportunidades para los creadores.

Alicia

Enorme.

Beto

Y lo que realmente marca este momento es la velocidad, la aceleración. Siento que la vida digital dio un salto de cinco, quizá diez años.

Alicia

Y gran parte de eso fue impulsado por la pandemia, que medio normalizó vivir, trabajar y, muy importante para este tema, el ocio en estas plataformas virtuales.

Beto

Así que la audiencia ya estaba ahí.

Alicia

La audiencia ya se estaba moviendo en línea y en números enormes. Quiero decir, mira algunas de las cifras de nuestro material fuente. Los ingresos de Nintendo en 2021 subieron algo así como un 46% respecto a 2019. Y toda la industria del videojuego alcanzó, ¿qué? 155.000 millones de dólares en 2020. Esto no fue un crecimiento lento. Fue un cambio masivo, casi de la noche a la mañana, hacia los espacios virtuales.

Beto

Así que los artistas no están entrando a un teatro vacío. Están entrando a un estadio lleno. La gente ya se siente cómoda pasando tiempo allí, gastando dinero.

Alicia

Exacto.

Beto

Así que nuestro análisis profundo de hoy trata de desempacar eso. Queremos entender cómo esta tecnología está cambiando fundamentalmente: ¿quién puede ser artista? ¿qué es siquiera el arte? Y quizá lo más importante para ti, ¿cómo se posee y valora en este extraño mundo nuevo?

Bien, empecemos por el motor que realmente le dio valor al arte digital, el motor económico. O sea, antes de todo esto, los artistas digitales tenían un enorme problema.

Alicia

Un problema de duplicación.

Beto

Correcto. ¿Cómo vendes una pieza única cuando cualquiera puede hacer clic derecho, guardar y tener una copia perfecta? El arte digital simplemente no tenía escasez.

Alicia

Y la respuesta de la industria a ese rompecabezas fue el "token no fungible", el NFT. Porque estos tokens funcionan sobre tecnología blockchain y crean, bueno, un registro públicamente reconocible de propiedad.

Beto

Se registra por todas las direcciones, ¿verdad? Así que todo el mundo puede verlo.

Alicia

Es transparente. Es descentralizado.

Beto

Así que, para que quede muy claro para quienes escuchan, el NFT es como un certificado de propiedad. Es una licencia sobre algo virtual. Pero en realidad no impide que yo, por ejemplo, haga una captura de pantalla de la imagen, ¿verdad?

Alicia

Para nada. Asegura el historial de propiedad, no el archivo en sí. Pero lo fascinante es la rapidez con la que la gente lo adoptó. Ese mecanismo, aún con sus fallos, fue suficiente para desatar este torrente de capital.

Beto

¿De cuánto estamos hablando?

Alicia

Las ventas de NFT llegaron a dos mil quinientos millones de dólares. Eso en apenas dos trimestres de 2021.

Beto

Se ve en los datos: el interés de búsqueda de “NFT” en Google y YouTube simplemente explotó en 2021. Pasó de prácticamente cero a un fenómeno global.

[NOTA: En el año 2025, los NFT han caído en desuso y han perdido su valor.]

Alicia

Sí. Y los ejemplos están por todas partes. Tuvimos proyectos tempranos como CryptoKitties: un gato digital raro se vendió por 600 ETH.

Beto

Solo para demostrar que la gente pagaría por la escasez digital.

Alicia

Exacto. Y ahora va mucho más allá de las imágenes estáticas. Los NFT se usan como coleccionables inteligentes en juegos como F1 Delta Time, donde tu token para un coche virtual tiene especificaciones únicas. Incluso medios tradicionales como "The Economist" vendieron una portada como un NFT.

Beto

De acuerdo, pero tenemos que equilibrar el entusiasmo. ¿Es esta explosión un cambio fundamental real de poder hacia los artistas? ¿O es solo otra burbuja de activos?

Alicia

Esa es la pregunta del millón. Y plantea enormes problemas de confianza y fraude. Quiero decir, más allá de simplemente tomar una captura de pantalla, existen estafas increíblemente sofisticadas. Mencionaste antes el “sleepminting”.

Beto

¿Cómo funciona eso? Creo que todo el punto del blockchain era su seguridad. Su inmutabilidad.

Alicia

Pues bien, explota el proceso. Un actor malintencionado puede acuñar una pieza falsificada directamente en la cartera de un coleccionista famoso sin que él lo sepa.

Beto

¿Qué?

Alicia

Sí. Luego puede vender esa copia “original”. Y el libro público parece mostrar que el coleccionista famoso fue el propietario primero. Así que parece legítimo. Desorienta por completo a los nuevos coleccionistas. Y, honestamente, socava toda la idea de procedencia.

Beto

Eso parece un agujero enorme en el sistema.

Alicia

Lo es. Y además de eso, no podemos ignorar los costos ambientales. La energía usada para minar y comerciar estos tokens es enorme. Crea una tensión real entre la libertad digital y la responsabilidad climática.

Beto

Así que el modelo económico todavía está, digamos, afinando sus fallos.

Pivoteemos de la propiedad a la experiencia real. Los bloques visuales del metaverso, empezando por CGI.

Alicia

CGI, "Computer-Generated Images": Imágenes generadas por computadora — están difuminando todas las líneas con los medios tradicionales, como la fotografía y el cine. (Ejemplo: Claudia Hart)

Beto

¿Te refieres a la fotografía virtual?

Alicia

Exactamente. Cuando compras muebles en línea, muchas de esas fotos perfectas de producto no son fotos. Son renderizados fotorrealistas por computadora. O mira a los influencers virtuales en Instagram, como @lilmiquela, un avatar totalmente digital integrado sin costuras en el mundo real.

Beto

Y lo contrario también está ocurriendo, lo que la fuente llama "fotografía aumentada".

Alicia

Sí. Usando escáneres 3D avanzados para capturar no solo luz y color, sino datos espaciales: distancias. Esto nos da registros 3D completos y de alta fidelidad de objetos físicos.

Beto

Como el retrato 3D del presidente Obama por el Smithsonian.

Alicia

Es un ejemplo perfecto. Es una técnica invaluable para, por ejemplo, el patrimonio cultural. Obtienes un registro digital completo de un artefacto, no solo una foto plana.

Beto

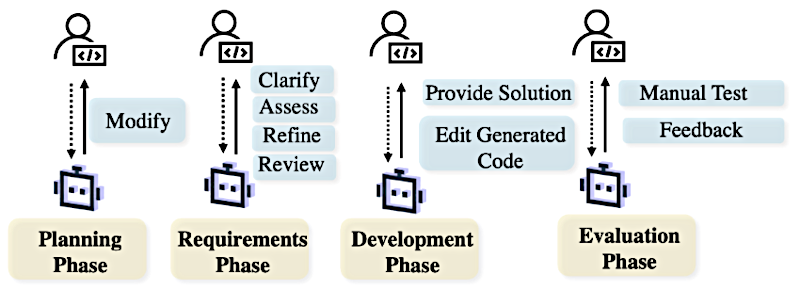

Así que pasando de imágenes estáticas a imágenes en movimiento, la simulación cinematográfica. ¿Cómo han cambiado las herramientas como Unreal Engine las cosas para los creadores?

Alicia

La revolución es el renderizado en tiempo real. Ese es todo el asunto. Tradicionalmente, hacías un cambio en una escena 3D, le dabas a “render” y luego esperabas horas, quizá días.

Beto

Recuerdo ese sufrimiento.

Alicia

Pero los motores de juego te dan retroalimentación instantánea. Mueves una luz, la sombra se mueve al instante; libera al artista para crear y experimentar en lugar de quedarse atrapado en ciclos de producción dolorosos.

Beto

Y eso ha llevado a arte que no está fijado en el tiempo.

Alicia

Totalmente. Arte que desafía lo que es el cine lineal.

Beto

Y aquí es donde se vuelve realmente alucinante: artistas que usan esta tecnología para crear simulaciones vivientes.

Alicia

Ves un par de enfoques principales. Primero, alguien como John Gerrard, que usa simulación en tiempo real para crear estos paisajes surrealistas infinitos. Reconstruye meticulosamente, por ejemplo, una instalación industrial y luego sincroniza la hora del día e incluso el tiempo atmosférico en su simulación con la ubicación física real.

Muestra de la obra de John Gerrard, fuente: Phileas.

Beto

¿Así que es como un retrato digital viviente de un lugar real?

Alicia

Exactamente eso. Un gemelo digital, pero como arte. Luego tienes a un artista como Ian Cheng, obsesionado con la idea de agencia. Hace simulaciones en vivo, o como él las llama, "videojuegos que se juegan solos".

Beto

Entonces el arte es crear su propia historia.

Alicia

Precisamente. Su pieza B.O.B (Bag of Beliefs) es esa cosa tipo serpiente impulsada por múltiples IA con objetivos distintos. Reaccionan al entorno en tiempo real. Él intenta crear lo que llama “sentiencia viable mínima”.

"Bob (Bags of Beliefs)", de Ian Cheng

Beto

¿Así que la narrativa simplemente se despliega por sí sola?

Alicia

Sí. Su trilogía Emissaries es lo que él llama "cine impulsado por eventos". No hay director. La historia es lo que ocurre cuando estos agentes de IA interactúan.

"Emissaries", por Ian Cheng. Fuente: MoMA

Beto

Bien. Las obras en movimiento están en camino de perfeccionarse en el metaverso. Pero no se trata solo de lo que vemos. ¿Y el texto? Si alguna vez has intentado escribir en un casco de RV, sabes que es torpe.

Alicia

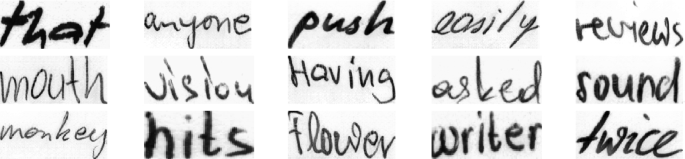

Es terrible. Y eso crea una gran oportunidad para las artes textuales impulsadas por IA. Los avances aquí son, francamente, notables, especialmente en caligrafía con IA.

Beto

¿Caligrafía?

Alicia

Sí. Tenemos modelos como GANwriting que pueden imitar la escritura humana — la redondez, el grosor del trazo — tan bien que la gente no puede distinguir entre la escritura de la máquina y la de un humano.

GANwriting. Fuente: Springer

Beto

Y esto se está volviendo hiperespecífico, ¿verdad?

Alicia

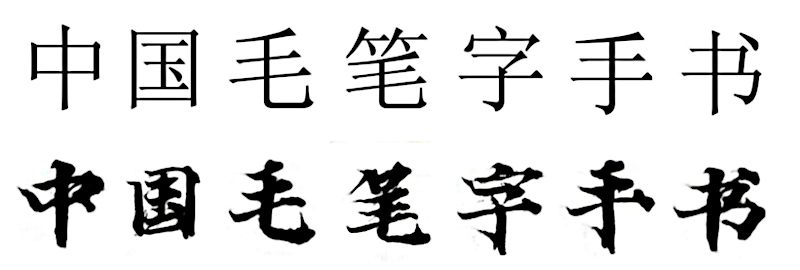

Increíblemente. Hay un modelo para caligrafía china llamado ZIGAN que puede aprender el estilo de un maestro tras ver apenas unos pocos ejemplos.

Caligrafía con ZIGAN.

Beto

¿Unos pocos ejemplos?

Alicia

Sí. Ese es el avance: la capacidad de absorber un estilo artístico complejo a partir de muy pocos datos. Es enorme.

Beto

Es asombroso. Y no es solo caligrafía, también es poesía.

Alicia

Absolutamente. Tenemos modelos como Deep-speare que generan versos de estilo shakesperiano que pueden engañar a humanos.

"Sonnet 18", ejemplo generado con Deep-speare:

-

Shall I compare thee to a summer’s day?

Thou art more lovely and more temperate:

Rough winds do shake the darling buds of May,

And summer’s lease hath all too short a date.

Y aún más, estos sistemas están aprendiendo a conectar diferentes formas de arte.

Hay un modelo que puede mirar una escena virtual, como “ciruelas rojas y nieve”, y generar poesía china que encaja perfectamente con el estado de ánimo.

Beto

Conecta lo visual con el lenguaje emocional.

Eso es el puente perfecto al sonido. Metacreación musical. ¿Cómo está cambiando el metaverso la forma en que hacemos y tocamos música?

Alicia

Está cambiando los propios instrumentos. A través de instrumentos musicales de realidad virtual (VRMIs), hay plataformas como PatchXR donde los artistas pueden construir instrumentos audiovisuales modulares en espacio 3D. No miras una pantalla, literalmente te mueves por el instrumento y conectas cosas.

Ejemplo de PatchXR:

Beto

¿Y la interpretación? Todos hemos visto conciertos virtuales, pero ¿qué los hace artísticamente distintos?

Alicia

Ofrecen perspectivas físicamente imposibles en la vida real: accesibilidad, libertad; sí, Madison Beer actuó como un avatar, por ejemplo.

Madison Beer, realidad inmersiva:

Pero piensa en la orquesta Philharmonia: En RV, la audiencia podría moverse justo al lado del director o situarse en medio de la sección de cuerdas.

"La Quinta de Beethoven", con la orquesta Philharmonia, en Realidad Virtual.

(requiere visores VR)

Beto

Eso no puedes hacerlo en Carnegie Hall. Un guardia de seguridad te tiraría al suelo.

Alicia

Exacto. Cambia por completo la experiencia del público. Pero todavía hay grandes obstáculos técnicos: Los chat rooms de RV se limitan a, ¿qué? ¿40 usuarios? Eso no es un concierto. Eso es un club pequeño.

Beto

Y el sonido todavía no está del todo logrado.

Alicia

Correcto. Un concierto real tiene ese caos auditivo: la gente, el murmullo. Es muy difícil simular eso de forma realista, así que los conciertos virtuales aún pueden sentirse un poco estériles.

Beto

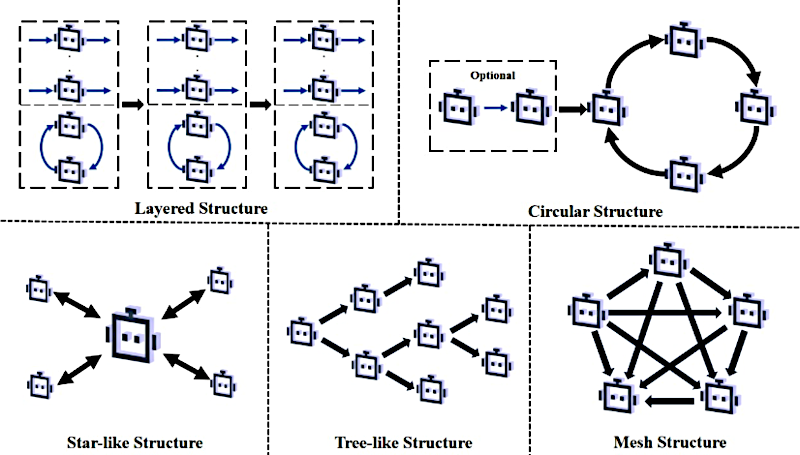

Lo que nos lleva a nuestra última frontera: la encarnación, donde artistas creados por humanos, IA e incluso robots físicos trabajan juntos. El ciclo de retroalimentación físico-digital.

Alicia

Y aquí la colaboración se vuelve realmente profunda. Toma a la artista Sougwen Chung. Ella trabaja con brazos robóticos que llama “Dougs” (Drawing Operation Units Generation").

Sougwen Chung, discurso en TED

Beto

¿Dougs?

Alicia

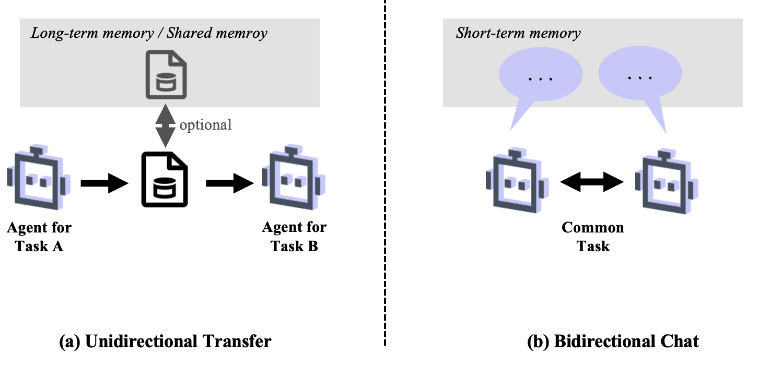

Sí, Dougs. Y están guiados por una IA que ha pasado una década aprendiendo sus gestos específicos, su estilo. La artista es física, pero la IA es como una extensión de su propia memoria y músculo.

Beto

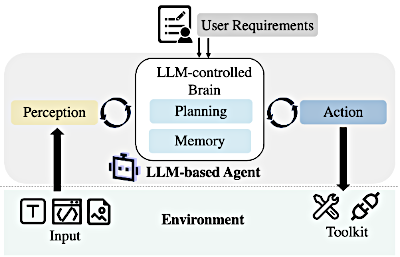

Y estamos incluso viendo arte impulsado por nuestros estados fisiológicos internos. Realidades extendidas, usando técnicas colectivas ExG como electro-encefalografía (EEG), electro-oculografía (EOG), electro-miografía (EMG).

Alicia

Esto es arte de estado interno. Es una locura. Hay prototipos como "Body Writing", un "wearable", un dispositivo que se pone en tu cuerpo, y que recoge datos sobre tus emociones, como tristeza o miedo. Luego una IA usa esos datos para escribirte un poema personalizado.

Beto

Espera. Entonces tus datos emocionales más íntimos se convierten en materia prima para el arte.

Alicia

Es increíblemente íntimo. Hubo otro proyecto, "EEG Kiss", que visualizó la actividad cerebral de los participantes durante un beso en tiempo real. Proyectó los datos en el suelo como pieza de arte.

Beto

Eso es o lo más romántico que he oído, o una pesadilla de privacidad.

Alicia

Un poco de ambos, quizá. Pero muestra cómo el cuerpo humano se está convirtiendo en un dispositivo de entrada.

Beto

Y si extiendes esa presencia física hacia fuera, llegas a la robótica y los drones convirtiéndose en artistas por sí mismos.

Alicia

En la música, tienes a Shimon, un robot que toca la marimba y puede improvisar con un músico humano. Reacciona a su emoción, a su estado de ánimo; incluso hay robots que tocan la flauta con labios artificiales.

Shimon, robotic marimba player:

Beto

Y pintores mecánicos.

Alicia

Esa tradición se remonta a las máquinas Metamatics de Jean Tinguely. Pero hoy tienes robots humanoides como Sophia, que vendió una pintura como NFT por casi 700.000 dólares.

Arte por Sophia:

Beto

Así que el mercado está valorando estas creaciones robóticas. Y luego tienes cosas a gran escala: drones.

Alicia

Los espectáculos de luces con drones son básicamente los nuevos fuegos artificiales, arte cinético colectivo masivo. Pero el desafío de seguridad es inmenso. Controlas cientos, a veces miles de estos aparatos a la vez. Se necesita GPS increíblemente preciso y comunicación constante para evitar colisiones.

Show reciente en Chongqing, China, con 11,787 drones

Beto

Hemos cubierto una enorme cantidad de terreno: NFT, IA generativa, robótica, arte con ondas cerebrales. Pero al mirar al futuro, tenemos que hablar de los desafíos. Porque la tecnología se mueve mucho más rápido que las reglas.

Alicia

Ese es el problema central. Necesitamos mejoras serias en el ecosistema. Quiero decir, por un lado hay una gran democratización ocurriendo. Herramientas de código abierto como Blender y Processing están haciendo la creación accesible para todos.

Blender 5.0

Arte con Processing

Beto

Pero los profesionales se están topando con paredes.

Alicia

Enorme. Tecnológicamente, la interoperabilidad sigue siendo una pesadilla. Simplemente intentar mover un modelo 3D complejo de un programa a otro es tan frustrante. Y necesitamos mejores maneras de manejar la enorme carga computacional del arte generativo en, por ejemplo, dispositivos móviles.

Beto

Y volviendo al mercado de los NFT, ¿qué brechas de gobernanza aún existen?

Alicia

Los mecanismos de comercio siguen siendo muy básicos. Es mayormente solo comprar y vender. Necesitamos protocolos robustos para arrendamiento y alquiler. El proyecto re-NFT está trabajando en esto, permitiéndote, por ejemplo, alquilar un NFT para exhibirlo en tu casa virtual durante un mes.

Beto

Eso es crucial para una economía madura. Sí.

Alicia

Lo es. Y más fundamentalmente, necesitamos mejor tecnología para prevenir copias no autorizadas. La licencia por sí sola no basta. Tenemos que construir la ejecución dentro de la tecnología misma para reducir el riesgo de cosas como el sleep-minting.

Beto

¿Y qué pasa con la gente? Los usuarios. Tocamos privacidad y seguridad.

Alicia

Es crítico. Las plataformas sociales en RV han documentado problemas de acoso y ciberbullying. Necesitamos mejor moderación. Y para los artistas, está el desafío de la intangibilidad. Un músico necesita sentir el instrumento. Necesitamos más investigación en guantes hápticos para cerrar esa brecha física en RV.

Beto

Si juntamos todo esto — la IA escribiendo poesía, los robots pintando —, ¿significa eso el fin del arte humano? Si una máquina puede ser tan creativa, ¿qué deja para el humano?

Alicia

Eso nos lleva a la gran cuestión filosófica del material fuente. Esta idea de una prueba Turing para las artes computacionales. Ya no es solo “¿pueden pensar las máquinas?” Es “¿pueden pensar y ser creativas?”.

Y tendemos a juzgar eso por dos cosas.

- Una: ¿puede un humano distinguir el arte de la máquina del arte humano?

- Y dos: ¿tiene la obra de la máquina el mismo valor estético?

Pero hay una trampa. Corremos el riesgo de descartar el arte computacional como superficial simplemente porque sabemos que lo hizo una máquina, porque seguía un algoritmo. Este mundo nuevo nos está obligando a decidir si valoramos el proceso o solo el resultado.

Beto

Hemos explorado este enorme y maleable lienzo del metaverso. Hemos visto de todo: desde NFT y sus riesgos hasta simulación cinematográfica, poesía por IA y arte hecho a partir de nuestras propias ondas cerebrales.

Alicia

Y si las herramientas de IA pueden escribir poesía indistinguible del trabajo humano y pintores IA pueden vender “originales” digitales por sumas enormes, ¿cómo definirán las generaciones futuras la originalidad? ¿Qué marco legal o tecnológico necesitaremos para realmente hacer cumplir la propiedad en un mundo donde, en teoría, todo puede copiarse infinitamente? Esa es la pregunta fundamental que este nuevo mundo debe responder. Y tú, el oyente, el creador, estás en la primera línea trazándolo.