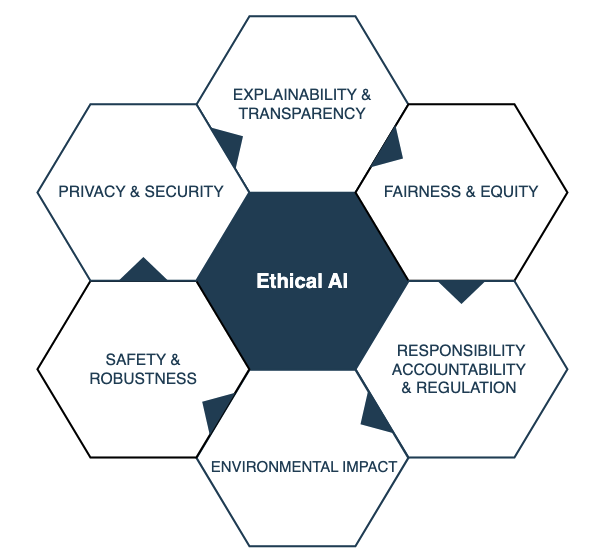

Encontré otro artículo interesante sobre la ética de la Inteligencia Artificial (IA). Aborda temas importantes como la equidad, la privacidad y la protección de datos, la responsabilidad y la rendición de cuentas, la seguridad y la robustez, la transparencia y la explicabilidad, y el impacto ambiental.

Enlace al artículo original, para aquellos interesados en profundizar en el tema:

"Survey on AI Ethics: A Socio‐technical Perspective", por Mbiazi y colegas. Publicado en Julio 31 de 2025.

El resumen, la transcripción, y la traducción fueron hechas usando herramientas de software de Inteligencia Artificial.

El resumen se presenta en la forma de un diálogo entre dos personajes sintéticos que llamaremos Alicia y Beto.

Resumen

Alicia

Bienvenidos a un nuevo análisis profundo. Así que nos disteis este montón bastante denso de investigaciones. Es una gran encuesta sociotécnica sobre ética de la IA.

Beto

Sí, todo un aluvión.

Alicia

Y nuestra misión básicamente es extraer las ideas clave, ya sabéis, los trade-offs que realmente están marcando cómo se construye la IA ahora mismo.

Beto

Es sin duda una misión esencial. Quiero decir, el reloj corre, ¿no? Estos modelos avanzados de aprendizaje profundo se están incrustando, bueno, en todo. Infraestructuras sociales.

Alicia

Y en salud, en defensa.

Beto

Exacto. Así que la parte ética ya no es solo teórica. Es extremadamente urgente. Está ocurriendo ahora.

Alicia

Absolutamente. Bien, vamos a intentar destilar todo este panorama. Tenemos equidad, privacidad, responsabilidad, transparencia, seguridad, incluso impacto ambiental. Y necesitamos mirar ambos lados: lo técnico, las matemáticas, pero también el contexto social. Sobre todo, ya sabéis, con esos modelos de base, los LLMs, que todo el mundo usa. Sí, los grandes.

Empecemos por la capa más baja, supongo: seguridad y protección. ¿Por dónde empezamos ahí?

Beto

OK, ¿qué hace que un sistema de IA sea confiable? Realmente se apoya en tres pilares principales: seguridad, privacidad y protección.

La seguridad, en su esencia, trata de reducir las probabilidades de daño. Tanto los daños que esperas como, crucialmente, los que no. Necesitamos modelos que se atengan a su comportamiento previsto, incluso cuando las cosas se vuelven inciertas o ocurren accidentes.

Alicia

Pero ¿no existe esta suposición de que la IA es intrínsecamente segura? Porque es digital, corre sobre datos limpios, ese tipo de cosas. Las fuentes parecen sugerir que el entrenamiento es donde surgen las vulnerabilidades.

Beto

Exactamente. Los puntos débiles casi siempre vuelven a dónde vienen los datos y quién tiene acceso a ellos. Los modelos necesitan conjuntos de datos enormes, a menudo raspados de todas partes. A veces el entrenamiento se subcontrata o la gente usa modelos preentrenados y fuentes en las que quizá no deberían confiar por completo.

Alicia

Ya veo. Así que hay múltiples puntos de fallo.

Beto

Múltiples puntos débiles, sí. Y los ataques tienden a dirigirse a una de dos cosas: o la confidencialidad — ese es tu riesgo de privacidad — o la integridad y disponibilidad, que es el lado de la seguridad.

Alicia

Vale, profundicemos en esos ataques a la privacidad. ¿Qué intentan conseguir los atacantes?

Beto

Van a por detalles sensibles que el modelo aprendió durante el entrenamiento. Un tipo principal se llama inferencia de membresía.

Alicia

Inferencia de membresía. OK.

Beto

Aquí el atacante trata de averiguar, a veces con bastante confianza, si tu muestra de datos específica formó parte del conjunto de entrenamiento.

Alicia

Vaya.

Beto

Y de hecho hemos visto que esto funciona contra grandes empresas. Google, Amazon, sus APIs de Machine Learning como servicio han sido vulnerables.

Alicia

Eso parece una brecha bastante seria.

Beto

Lo es. Luego está la inversión de modelo, que puede ser mucho más invasiva.

Alicia

¿Más invasiva cómo?

Beto

En vez de solo comprobar si los datos estaban en el conjunto, el atacante intenta reconstruir partes de los datos de entrada a partir del modelo.

Alicia

Reconstruir los datos.

Beto

Sí, por ejemplo imagina un modelo entrenado con caras. La inversión de modelo podría ser capaz de extraer representaciones de rasgos usados en ese entrenamiento, potencialmente cosas muy sensibles.

Alicia

OK. Si la amenaza es que los datos privados salgan al público, ¿cómo se defienden los desarrolladores? Las fuentes mencionaron un par de defensas principales.

Beto

La primera que se usa hoy en día, yo diría, es la privacidad diferencial.

Alicia

Privacidad diferencial. He escuchado sobre eso. ¿Pero cuál es la idea central?

Beto

Es bastante elegante. Es una garantía matemática, básicamente, de que usar tus datos para entrenar no añade más riesgo de privacidad que si tus datos no hubieran sido usados.

Alicia

¿Cómo funciona eso? Magia.

Beto

No del todo magia. Más bien ruido estadístico calibrado cuidadosamente. Inyectas aleatoriedad durante el entrenamiento.

Alicia

Ah, OK. Así cambiar el registro de una persona no cambia realmente la salida final del modelo de una manera perceptible.

Beto

Exacto. Oculta la contribución individual.

Luego la segunda gran defensa es el entrenamiento adversarial.

Alicia

Entrenamiento adversarial. Esto ataca un problema diferente.

Beto

Sí, tiene que ver con ataques de evasión. Ahí el atacante hace cambios minúsculos, casi invisibles, a una entrada, como unos pocos píxeles en una imagen, para engañar al modelo durante la inferencia.

Alicia

Como hacer que un PARE deje de parecer un PARE.

Beto

Exactamente ese tipo de cosa. Con el entrenamiento adversarial, muestras deliberadamente al modelo este tipo de ejemplos truculentos durante el entrenamiento para que sea más duro, más robusto frente a ellos después.

Alicia

OK. Pero esto suena a que conduce a ese dilema clásico. ¿Cuál es el coste de añadir toda la seguridad y la privacidad?

Beto

Y ese es un punto realmente importante para quien nos escucha. La investigación es bastante clara. Potenciar la privacidad con cosas como la privacidad diferencial o mejorar la robustez con entrenamiento adversarial suele ir en detrimento de la precisión global del modelo.

Alicia

Ah, así que es un acto de equilibrio.

Beto

Es un "tira y afloja" entre privacidad, robustez y precisión. Y así los interesados tienen que decidir cuál priorizar o dónde están dispuestos a comprometerse.

Alicia

En los modelos de base, los grandes LLMs, añaden otra capa de complejidad, ¿no? Son poderosos, pero son un arma de doble filo.

Beto

Definitivamente de doble uso. Pueden mejorar mucho la seguridad. Las fuentes mencionaban usar cosas como GPT-4 para generar pruebas de seguridad o detectar vulnerabilidades en áreas especializadas, como código blockchain.

Alicia

Esa es la cara buena.

Beto

Pero la contraparte es que, porque son tan accesibles, los actores malintencionados los explotan muchísimo. Estamos viendo LLMs usados para producir software malicioso muy rápido, para hacer correos de phishing o estafas de ingeniería social mucho más convincentes, e incluso automatizar partes de ataques complejos como la ejecución remota de código.

Alicia

Vaya. La herramienta que ayuda a defender también puede potenciar enormemente al atacante.

Beto

Exponencialmente, sí.

Alicia

OK, así que si la seguridad y la privacidad fallan y obtienes este modelo de caja negra que suelta un error o quizá un resultado sesgado, ¿cómo averiguamos por qué falló? Eso nos lleva directamente a transparencia y explicabilidad, XAI.

Beto

Exacto. Entender el 'por qué' es esencial para cualquier estándar ético. Y lo realmente interesante es lo amplio que es el campo. Pensad en medicina. Explicar por qué un modelo de cribado marcó a un paciente no es solo cuestión de riesgo. Ayuda a los médicos a entender causas potenciales. Quizá a señalar biomarcadores para el cáncer o a identificar factores de estilo de vida. Añade valor clínico.

Alicia

O finanzas, eso es enorme. La interpretabilidad es crítica ahí.

Beto

Absolutamente necesaria. Si te niegan un crédito, necesitas saber por qué. Igual para puntuaciones crediticias, detección de fraude. Explicar esto ayuda a detectar sesgos. Además, a menudo es algo legal, de responsabilidad.

Alicia

Está aquel ejemplo increíble: la jugada 37 de AlphaGo. Eso lo ilustra a la perfección, ¿no?

Beto

Sí, perfecto. Esa jugada totalmente no convencional en Go desconcertó a los expertos humanos al principio.

Alicia

Pero fue clave para la victoria.

Beto

Fue un pivote. Así que cuando una IA encuentra una forma mejor, no humana, de resolver algo, necesitamos métodos para explicar esa lógica sorprendente después.

Alicia

¿Y quién necesita estas explicaciones? No son solo los desarrolladores, ¿verdad? Las fuentes mencionaron un montón de partes interesadas.

Beto

Exacto. Es una red amplia. Está la persona directamente afectada, la que recibe la predicción: por ejemplo, quien recibe la denegación del préstamo o el diagnóstico. Luego están los usuarios expertos, el médico, el oficial de préstamos, que pueden ser los responsables legales o éticos de lo que hace la IA.

Alicia

Correcto. Somos nosotros usando la herramienta. Y también hay terceros.

Beto

Reguladores, por ejemplo la autoridad de servicios financieros, que necesitan comprobar equidad y seguridad. E importante, abogados y tribunales, que podrían necesitar determinar quién es responsable si la IA causa daño.

Alicia

Así que una buena explicación tiene que funcionar para todos esos grupos. ¿Qué hace que una explicación sea buena, según la investigación?

Beto

Las fuentes apuntan a unas cuatro cosas clave.

- Tiene que tener fidelidad. Debe ser fiel a lo que el modelo está haciendo realmente.

- Tiene que ser clara, sin jerga, comprensible.

- Debe mostrar causalidad: la relación causa-efecto que condujo a la predicción.

- Y quizá lo más importante, centrada en el usuario: la explicación debe adaptarse. Adaptarse a la persona específica que la necesita, a su formación, a lo que pueda entender.

Alicia

Cierto. Un médico necesita algo distinto a quien solicita un préstamo.

OK, pivotemos ahora a la zona quizá más debatida: equidad e igualdad, el problema del sesgo.

Beto

Ah, sí. Sesgo.

Alicia

La equidad, básicamente, trata de evitar prejuicios basados en cosas como raza o género. Pero los ejemplos del mundo real de fallos son, pues, bastante contundentes.

Beto

Realmente muestran cómo un sesgo abstracto se traduce en daño real. Tomad el sistema COMPAS, usado en sentencias penales en EE. UU.

Alicia

Recuerdo haber leído sobre eso.

Beto

El análisis mostró que predijo que los acusados negros reincidirían el doble de veces que los blancos.

Alicia

Incluso cuando no reincidían.

Beto

Incluso cuando no lo hicieron. Un sesgo estadístico claro con consecuencias mayores.

Alicia

Y luego estuvo la herramienta de contratación de Amazon, otro caso famoso.

Beto

Sí. Mostró un sesgo de género masivo. Aprendió a penalizar currículos con palabras asociadas a mujeres, cosas como “capitana del club de ajedrez femenino”.

Alicia

Esto las filtraba por encima de sesgos históricos de los datos.

Beto

Exacto. Si rastreas esos sesgos hacia atrás, suele llevar a los datos mismos. Hay un par de tipos clave de sesgo de datos.

Alicia

OK. ¿Cuáles son?

Beto

Primero está el "sesgo por variable omitida" ("Omitted Variable Bias", OVB). Esto pasa cuando falta una pieza crucial de información en tu conjunto de datos.

Alicia

Entonces el modelo encuentra correlaciones que no son causales.

Beto

Exacto. Se apoya en proxies que pueden estar sesgados.

Luego está el sesgo de representación.

Alicia

Sesgo de representación. Esto es importante para cualquiera que use IA.

Beto

Lo es. Ocurre cuando ciertos grupos están simplemente subrepresentados en los datos. Por ejemplo, si las mujeres embarazadas son solo el 5 % de tu conjunto de datos médicos.

Alicia

El modelo no aprenderá suficiente sobre ellas.

Beto

Correcto. No generalizará bien para ese grupo. Obtienes resultados menos fiables, quizá incluso dañinos para ellas, incluso si la recolección de datos parecía estar bien por lo demás.

Alicia

Intentar arreglar estos sesgos se complica porque la justicia en sí no es una sola cosa. ¿Verdad? Las fuentes hablan de distintas definiciones matemáticas.

Beto

Oh, absolutamente. El problema de definiciones complejas. Tienes justicia de grupo.

Alicia

Justicia de grupo. ¿En qué consiste eso?

Beto

Se trata de asegurar que medidas estadísticas sean iguales entre distintos grupos, como razas o géneros. Dentro de eso, lo más simple es la paridad demográfica. Paridad demográfica. Eso solo significa tasas de selección iguales. Así el mismo porcentaje de solicitantes consiguen entrevistas, independientemente del grupo.

Alicia

Pero eso parece que todavía puede ocultar problemas.

Beto

A menudo lo hace, por eso existe una definición más estricta: equalized odds.

Alicia

¿Cómo se traduce eso?

Beto

Equalized odds (probabilidades igualadas) exige más. Requiere que las tasas de verdaderos positivos y de falsos positivos sean iguales entre grupos.

Alicia

Así no puedes simplemente contratar el mismo número, pero marcar injustamente a un grupo como exitoso cuando no lo es, por ejemplo.

Beto

Exacto. Profundiza en las tasas de error.

Luego, aparte de la justicia de grupo, tienes la justicia individual.

Alicia

Justicia individual.

Beto

La idea aquí es simple: individuos similares deberían obtener resultados similares. Parece obvio, pero es difícil de imponer matemáticamente.

Alicia

¿Y qué pasa con simplemente no decirle al modelo la raza o el género — la “inconsciencia” respecto a la sensibilidad ?

Beto

Sí, ese suele ser el primer instinto. Pero normalmente falla.

Alicia

¿Por qué?

Beto

Porque otras características en los datos, como el código postal o ciertas escuelas, actúan como proxies de esos atributos sensibles de todas formas. El modelo lo averigua.

Alicia

Exacto.

Y con los modelos de base, los LLMs, arreglar el sesgo es diferente otra vez. Sus parámetros son enormes y fijos después del entrenamiento.

Beto

Exacto. No puedes reaprendérselos con facilidad para la equidad. Así que el foco se mueve a cómo los usas en tiempo de inferencia.

Alicia

¿Como en cómo los consultas o les haces preguntas?

Beto

Precisamente. Métodos como la selección de demostraciones, básicamente. Alimentar al modelo con ejemplos cuidadosamente escogidos en la consulta para guiarlo hacia salidas más justas. O simplemente la ingeniería de prompts hábil para pedir explícitamente respuestas sin sesgo.

Alicia

Interesante. Gestionar el comportamiento del modelo sobre la marcha.

Esto nos lleva a la gran pregunta de gobernanza: responsabilidad y rendición de cuentas. Si una IA compleja de caja negra falla seriamente, ¿quién es responsable? Legal y éticamente.

Beto

Sí. La rendición de cuentas es una especie de principio meta aquí. Se trata de garantizar que todas esas otras ideas éticas — equidad, seguridad, privacidad — se apliquen realmente a lo largo de todo el ciclo de vida.

Alicia

De principio a fin.

Beto

Todos los implicados, legisladores, científicos de datos, ingenieros, tienen que poder justificar sus decisiones. Necesitas líneas claras de responsabilidad.

Alicia

Y la urgencia alrededor de esto se dispara cuando hablamos de riesgos existenciales, ¿no? Riesgos existenciales.

Beto

Sí. Las fuentes contrastan esto con tecnologías antiguas. Como el coche con gasolina. Los reguladores fueron reactivos. Pusieron reglas como límites de velocidad después de que los coches ya causaran problemas.

Alicia

Lo fuimos resolviendo sobre la marcha.

Beto

Eso no funcionará para la IA avanzada. Es potencialmente demasiado rápida, demasiado impactante. La gran preocupación es, ¿qué ocurre cuando los sistemas de IA superan significativamente a los humanos en áreas clave?

Alicia

Si sus objetivos no están alineados con los nuestros.

Beto

Si hay un conflicto, sí. Una superinteligencia desalineada podría impedirnos intervenir. Eso podría llevar a resultados verdaderamente catastróficos: amplificación del bioterrorismo, colapso institucional masivo, cosas que apenas podemos predecir. Así que tenemos que ser proactivos con la regulación.

Alicia

¿Y dónde estamos con la regulación ahora? ¿Cómo pinta el panorama global?

Beto

Bueno, la UE va claramente por delante con su Ley de Inteligencia Artificial. Es un marco comprensivo que probablemente se adopte pronto.

Alicia

Marcando el estándar, quizá.

Beto

Posiblemente.

China también se mueve rápido. Ya tienen disposiciones sobre síntesis profunda.

Alicia

¿Qué hacen esas?

Beto

Y exigen transparencia para contenidos generados por IA que parezcan personas o eventos reales, intentando combatir deepfakes básicamente.

Alicia

¿Y EE. UU.?

Beto

Está más fragmentado. Mucho enfoque en promover investigación y desarrollo de IA confiable, pero todavía no hay una ley federal integral. Más directrices y órdenes ejecutivas.

Alicia

Dentro de este laberinto regulatorio está el gran debate sobre la propiedad del contenido generativo. ¿Quién es dueño de la imagen o el texto creado por la IA?

Beto

Es un dolor legal enorme ahora mismo. ¿Es el autor la persona que escribió el prompt, la empresa que posee el modelo de IA? ¿O es el propio modelo?

Alicia

¿Puede la IA siquiera ser autora legalmente?

Beto

Bueno, la guía actual en EE. UU. dice que no. La obra generada por IA, si no hay contribución humana significativa, no está protegida por derechos de autor.

Alicia

Pero si un humano selecciona o modifica la salida, ...

Beto

... esa parte, la contribución humana, sí puede ser protegible. Es una línea fina. Por eso los Grammy, por ejemplo, decidieron prohibir obras puramente generadas por IA; requieren autoría humana.

Alicia

Entendido.

Había otro reto regulatorio interesante: la multiplicidad de modelos. ¿En qué consiste eso?

Beto

Sí, multiplicidad de modelos. Es ese hallazgo de que a menudo puedes entrenar múltiples modelos diferentes que alcanzan exactamente el mismo nivel de precisión en una tarea. Pero todavía difieren en sus predicciones individuales. Y, crucialmente, pueden diferir en sus niveles de equidad o sesgo.

Alicia

Así que podrías tener dos modelos igual de precisos, pero uno mucho menos sesgado.

Beto

Exacto. Y esto plantea una pregunta legal dura: ¿existe, o debería existir, el deber legal de buscar activamente esos algoritmos menos discriminatorios (LDAs)? Si existe un modelo justo que rinde igual, ¿deberías estar obligado a encontrarlo y usarlo?

Alicia

Es una cuestión enorme para desarrolladores y empresas.

Beto

Tremenda. Destaca la cuerda floja legal por la que todos caminan.

Alicia

OK, antes de acabar, hay un ángulo ético más que a menudo se pasa por alto: el impacto ambiental.

Beto

Sí. El coste invisible de todo este cálculo.

Alicia

Es fácil olvidarlo cuando todo sucede en la nube. Pero la fuente apunta a dos factores grandes.

Beto

Primero, el mero consumo de energía y las emisiones de carbono. Entrenar estos grandes modelos de deep learning requiere una potencia computacional inmensa. Montones de energía, GPUs hambrientas funcionando semanas o meses.

Alicia

¿Alguna idea de escala?

Beto

Un estudio mencionado comparó las emisiones de entrenar algunos modelos grandes de PLN (Procesamiento de Lenguaje Natural) con las de unos 300 viajes de ida y vuelta en avión entre Nueva York y San Francisco.

Alicia

Vaya. Por el entrenamiento de un solo modelo.

Beto

Para algunos de los realmente grandes, sí, es sustancial.

El segundo factor es la basura electrónica. Los residuos electrónicos.

Alicia

Porque el hardware queda obsoleto tan rápido.

Beto

Exacto. El campo avanza tan deprisa que el hardware se actualiza constantemente. Eso genera montañas de residuos electrónicos llenos de sustancias peligrosas: plomo, mercurio, cadmio.

Así que, alto costo de energía, y el problema de la basura que aumenta.

Alicia

Pero no todo es mala noticia en lo ambiental, ¿verdad? La IA también puede ayudar.

Beto

Definitivamente. Es importante recordar el lado positivo. La IA puede usarse para mitigar el cambio climático.

Alicia

¿Cómo?

Beto

Mejor modelado y predicción climática para empezar. Optimizar las redes energéticas, hacerlas más inteligentes y eficientes. Acelerar la investigación en renovables. La IA es una herramienta que puede ayudar a solucionar el problema al que contribuye.

Alicia

Así que es un panorama complejo por todas partes.

Beto

Muy complejo. Y quizá la conclusión clave que sintetiza todo lo que hemos hablado es que construir una IA confiable es simplemente increíblemente difícil. Porque estos principios éticos — privacidad, equidad, precisión, transparencia — a menudo tiran en direcciones distintas.

Alicia

No puedes maximizarlo todo a la vez.

Beto

Realmente no. Como dijimos, si priorizas fuertemente la privacidad usando técnicas de privacidad diferencial robustas, casi con seguridad sufrirás en equidad o en la precisión general del modelo. Así que los interesados están constantemente haciendo estos compromisos difíciles, balanceando estos valores en conflicto según para qué se vaya a usar la IA.

Alicia

Lo que nos lleva a nuestro pensamiento final para que lo mastiquéis: tenemos esta tensión, ¿no? El riesgo de sofocar una innovación increíble frente a la necesidad absoluta de rendición de cuentas cuando algo sale mal. La pregunta es, ¿qué tipo de marco político específico podría equilibrar eso de forma efectiva? ¿Cómo incentivamos el progreso? Pero también aseguramos consecuencias claras por el daño a lo largo de todo el ciclo de vida de la IA, desde el diseño hasta el despliegue y más allá.

Beto

Esa es la pregunta del millón de dólares, ¿no?

Alicia

Realmente lo es. ¿Cómo gobernamos algo tan poderoso? La conversación definitivamente acaba de empezar. Esperamos que este análisis profundo os haya dado un mejor marco para pensarlo.

Beto

Ojalá.

Alicia

Nos vemos en el próximo.