Las personas de trabajo intelectual, los llamados "empleados de cuello blanco", muy pronto se verán reemplazados por la Inteligencia Artificial (IA). Eso ya es un hecho, y la gente ya se está empezando a preocupar.

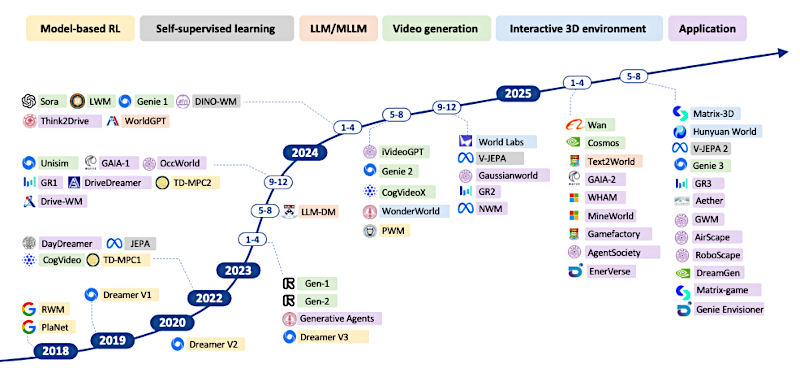

En este momento se construyen los "modelos del mundo", la estructura conceptual que hará posible que los robots se muevan en, y entiendan, un espacio-tiempo, y esto hará posible que reemplazen eventualmente el trabajo de los empleados de "cuello azul", la gente que trabaja con las manos (laboradores de las fábricas, carpinteros, electricistas, plomeros, etc). Hoy les traigo un resumen que habla sobre estos modelos del mundo.

Enlace al artículo original en inglés, para aquellos interesados en profundizar en el tema: "Understanding World or Predicting Future? A Comprehensive Survey of World Models", por Jingtao Ding y colegas. Publicado el 15 de Noviembre del 2025.

El resumen, la transcripción, y la traducción fueron hechas usando herramientas de software de Inteligencia Artificial.

El resumen se presenta en la forma de un diálogo entre dos personajes sintéticos que llamaremos Alicia y Beto.

Resumen

Beto

Bienvenidos a un nuevo análisis profundo, el lugar donde cortamos el ruido para entender las ideas fundamentales que impulsan el futuro de la tecnología.

Hoy estamos lidiando con un concepto que es realmente central para toda la búsqueda de la inteligencia artificial general, o AGI. Hablamos de los "modelos del mundo".

WMs: World Models = Modelos del mundo

Alicia

Modelos del mundo, (o "World Models", WMs), han explotado fuera de la academia recientemente. Los ves por todas partes. Y es sobre todo por dos tipos de sistemas muy diferentes. Por un lado tienes algo como GPT-4, que parece entender el mundo a través del lenguaje, a través de la lógica.

Beto

Y por otro lado tienes modelos como Sora, que parecen simular la realidad física con un realismo simplemente sobrecogedor.

Alicia

Exacto.

Beto

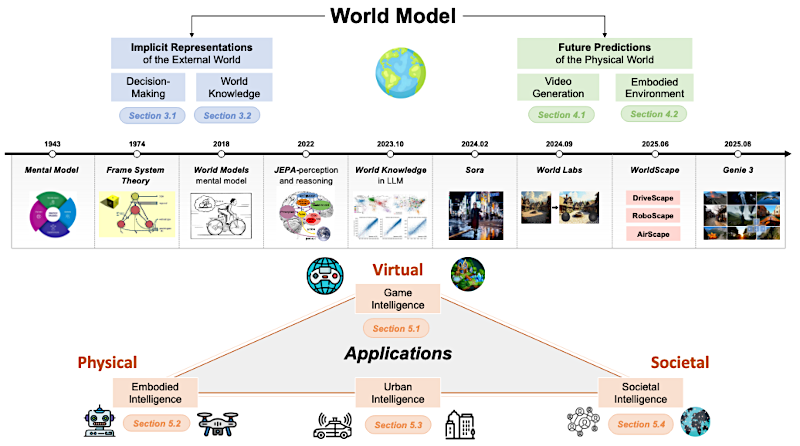

Y nuestro material base para esto, una encuesta académica realmente exhaustiva, define los modelos del mundo descomponiéndolos en dos funciones esenciales. Y a menudo parecen tirar en direcciones opuestas.

Funciones de WMs

Primero, sirven para comprender el mundo construyendo estas imágenes internas abstractas del mismo. Ese es el conocimiento implícito.

Alicia

Y segundo, sirven para predecir qué va a pasar después, la dinámica explícita. Para que un agente pueda tomar decisiones.

Beto

Vamos a usar esos dos pilares para estructurar esta inmersión porque te ayuda a ver que los modelos del mundo son mucho más que generadores de vídeo sofisticados.

Alicia

Y antes de entrar en lo moderno, en la arquitectura, realmente necesitamos situarnos en el contexto histórico. La idea de un modelo del mundo artificial no es nada nueva. Tiene raíces increíblemente profundas en la psicología. Hablamos de la formalización de los modelos mentales.

Beto

Modelos mentales. Vale, eso encaja. Suena muy humano. Como internalizar las reglas de un juego antes incluso de empezar a jugar.

Alicia

Exactamente eso. La idea fundacional llega hasta el psicólogo escocés Kenneth Craik en 1943. Él sostuvo que la mente humana no procesa los datos sensoriales crudos directamente; en vez de eso construye estos modelos abstractos a pequeña escala de lo que está ocurriendo afuera.

Beto

Usamos esos modelos para ejecutar simulaciones en la cabeza y predecir qué pasará después.

Alicia

Antes de que ocurra en realidad, es como si todos lleváramos réplicas predictivas diminutas del universo en la cabeza.

Beto

Es una gran forma de decirlo.

Alicia

Esa idea fue luego formalizada por el científico cognitivo Philip Nicholas Johnson-Laird en los años ochenta. Mostró que el razonamiento humano, ya sea que estés resolviendo un rompecabezas lógico o simplemente cruzando una calle concurrida, involucra construir y manipular esos "modelos mentales". Así que el principio es el mismo para nosotros o para una IA. Abstractas la realidad en estas representaciones internas finitas para poder razonar sobre el futuro.

Beto

Es el atajo definitivo, ¿no? Un modelo finito de un mundo potencialmente infinito. Captura las relaciones, no cada pequeño detalle.

Bien, desgranemos esto. Comenzando con la mitad de comprensión de la ecuación. Cómo la IA construye ese conocimiento interno implícito.

Alicia

La base técnica aquí viene realmente del "aprendizaje por refuerzo basado en modelos", o MBRL por sus siglas en inglés ("Model-Based Reinforcement Learning"). Este es el campo donde un agente aprende las reglas de su mundo no solo por prueba y error, sino construyendo de hecho un modelo del mismo.

Beto

Esto suena como el punto en que los agentes empiezan a actuar menos como robots y más como, no sé, filósofos digitales. Aprenden las reglas y luego las interiorizan.

Alicia

Exactamente.

Pioneros tempranos como Ha y Schmidhuber allá por 2018 propusieron usar estos modelos implícitos para aprender representaciones latentes. Y el beneficio clave es la simulación. En vez de costoso y lento ensayo y error en el mundo real, el agente usa su modelo del mundo. Puede generar una especie de simulación mental de lo que podría pasar si realiza cierta acción.

Beto

Se imagina el futuro antes de actuar, que es donde entran sistemas como la serie Dreamer de Google DeepMind.

Alicia

Dreamer V3 es el ejemplo perfecto de cómo escala esto. Usando estas representaciones de mundo aprendidas, este aprehensión interna de cómo funciona su entorno, Dreamer V3 pudo dominar todo tipo de tareas diferentes. Incluso resolvió problemas increíblemente complejos como recolectar diamantes en Minecraft. Piensa en eso. Requiere navegación, uso de herramientas, planificación a largo plazo.

Beto

Y lo hizo todo solo a partir de su modelo aprendido, ¿verdad? Sin datos humanos, sin ajustes especiales para Minecraft.

Alicia

Nada. Solo generalización desde su entendimiento interno.

Beto

Bien, pasemos a la columna vertebral del lenguaje, que al principio resulta un poco contraintuitiva. Que los grandes modelos de lenguaje, solo por leer la internet, también construyen este tipo de conocimiento implícito del mundo. Me recuerda a esa cita de Ludwig Wittgenstein, "los límites de mi lenguaje significan los límites de mi mundo".

Alicia

Esa cita es increíblemente relevante para los LLMs. El material fuente apunta a investigaciones nuevas que muestran que realmente adquieren comprensión espacial y temporal. No es solo estadística sobre qué palabras aparecen juntas. Algunos estudios han encontrado neuronas espaciales y neuronas temporales distintas en modelos como Llama 2.

Beto

Cuando dices neuronas en vectores de alta dimensión, eso sigue siendo bastante abstracto. ¿Puedes pintar una imagen rápida de lo que eso realmente significa para nosotros?

Alicia

Claro. Piénsalo como una firma digital única para un concepto, quizá "París" o "correr". En vez de un solo número, la firma tiene miles de cualidades medibles. Y si las imaginas como ejes en un gráfico, los investigadores han encontrado que ciertos ejes se alinean consistentemente con conceptos como "está cerca de" o "ocurrió en el pasado".

Beto

Así que el LLM no solo sabe que Nueva York está al lado de Nueva Jersey porque vio la frase un millón de veces. Tiene una especie de mapa latente estructurado donde esas cosas existen relativas entre sí. Lo que le permite hacer predicciones bastante sofisticadas sobre el mundo real.

Alicia

Precisamente. Y esta habilidad incluso se extiende a la dimensión social, a modelar lo que se llama "teoría de la mente": la capacidad de adivinar los estados mentales, las creencias, las intenciones de otras personas.

Beto

Hemos visto tanto debate sobre esto, ¿verdad? Si GPT-4 realmente tiene teoría de la mente o si solo es un imitador increíblemente bueno.

Alicia

Bueno, es muy complejo. La investigación muestra que modelos como GPT-4 son decentes en tareas simples de teoría de la mente. Pero realmente empiezan a desmoronarse comparados con los humanos cuando las cosas se vuelven sutiles. Por ejemplo, tienen problemas con pruebas de faux pas (situaciones sociales embarazosas de equivocaciones o errores). Ahí no solo hay que entender qué pasó, sino cómo se sintieron las personas involucradas y qué creían. A menudo basado en información incompleta. Pueden modelar la mecánica de la sociedad, pero esa parte emocional y matizada de las creencias sigue siendo un obstáculo enorme.

Beto

Si la sutileza social es tan difícil, cambiemos y miremos los modelos que se enfocan puramente en pronosticar el mundo físico. Las dinámicas explícitas de predicción. Aquí es donde se pone realmente interesante.

Alicia

Esto nos lleva directamente al mundo de la generación de vídeo. Modelos como Sora. Son absolutamente el enfoque principal ahora mismo para el modelado explícito del mundo. El objetivo es simular cómo evoluciona el mundo con el tiempo, generando estas secuencias visuales que muestran una comprensión aprendida, aunque a veces frágil, de la física.

Beto

Y cuando ves uno de esos vídeos de Sora hiper-realistas, tu primer instinto es que debe entender la física. Quiero decir, las cosas se equilibran, se mueven, todo parece plausible.

Alicia

Se ve plausible, y esa capacidad es notable. Pero el debate clave, y nuestras fuentes lo analizan a fondo, es si la plausibilidad visual es lo mismo que el entendimiento mecanicista. A pesar del realismo, Sora y modelos similares tienen enormes limitaciones en razonamiento causal. A menudo fallan en acertar consistentemente la física compleja. Piensa en dinámica de fluidos o en cómo la luz se refleja de forma consistente, o cómo se comporta un objeto si aplicas la misma fuerza repetidamente.

Beto

Bien, pero si el vídeo parece perfecto para un humano, ¿por qué importa tanto el motor subyacente? ¿Qué se rompe realmente si la física es solo plausible visualmente?

Alicia

Esa es la diferencia crítica entre generación y generalización. El momento en que intentas usar estos sistemas para decisiones del mundo real — robótica, coches autónomos — esos pequeños fallos físicos se vuelven fallos catastróficos. Si un modelo sabe cómo se ve lo que pasa, pero no por qué pasa causalmente, no se le puede confiar para predecir qué ocurrirá cuando las condiciones cambien, aunque sea un poco. Lo que los investigadores llaman "escenarios fuera de distribución".

Beto

Lo que hace que el paso de la generación pasiva de vídeo hacia simulaciones corporizadas e interactivas sea absolutamente crítico.

Alicia

Es un cambio fundacional. Es para cualquier agente inteligente que necesite actuar en el mundo, no solo observarlo. Para la robótica, los WMs son esenciales porque guían las acciones permitiendo al robot imaginar diferentes futuros. Y para eso necesitas una representación explícita y precisa de cómo funciona realmente el entorno para cosas como agarrar o navegar.

Beto

¿Puedes darnos un ejemplo realmente potente desde la robótica?

Alicia

Apuntaría a Daydreamer. El entrenamiento tradicional de robótica ocurre en simulación, y siempre hay esta enorme brecha de realidad. Las cosas que funcionan en el simulador simplemente no funcionan en el mundo real. Daydreamer usa su modelo del mundo para aprender la dinámica del mundo real, permitiendo a los robots aprender tareas súper complejas como caminar en el mundo físico en apenas unas horas. El WM puentea esa brecha.

Beto

Y otra área enorme que ya está impactando nuestras vidas es la inteligencia urbana, específicamente la conducción autónoma.

Alicia

Allí los WMs son obligatorios. No hay forma de evitarlo. Un sistema de conducción autónoma tiene que fusionar todos estos datos en tiempo real — cámaras, lidar, radar — y luego predecir cómo va a evolucionar el tráfico varios segundos en el futuro. No estamos hablando de predecir la siguiente palabra en una frase. Hablamos de predecir el mundo físico.

Beto

Entonces, ¿en qué se diferencia el modelo del mundo de un coche autónomo del de un LLM?

Alicia

Es todo sobre generar datos de sensores futuros. Estos simuladores de extremo a extremo como GAIA-1 o Drive-WM no están entrenados para generar futuras oraciones. Están entrenados para generar futuras grillas de ocupación. Estos mapas 3D de dónde estarán los objetos y el espacio libre, o futuras lecturas de lidar. Esa predicción espacial explícita es lo que el módulo de planificación del coche necesita para navegar con seguridad. Sin eso, el coche conduce a ciegas.

Beto

Si amplías la perspectiva, el rango de aplicaciones para los WMs es impresionante. Va mucho más allá de los grandes modelos generativos de los que oímos todos los días. Esto realmente se siente como el núcleo de la discusión.

Alicia

Absolutamente. Quiero decir, toma los videojuegos. Los WMs están cambiando por completo cómo se construyen los mundos virtuales. Los juegos siempre han dependido de reglas codificadas manualmente, ¿no? Lo que hace que todo se sienta muy estático.

Beto

Claro. Si pongo una taza en una mesa en un juego de rol, salgo de la habitación y vuelvo, esa taza va a estar exactamente donde el guión dice que está.

Alicia

Precisamente. Los WMs rompen eso. Permiten mundos virtuales dinámicos y reactivos que pueden crear nuevo contenido por sí solos y adaptarse a lo que hace el jugador. Mira un modelo llamado WHAM, el modelo de mundo y acción humana ("World and Human Action Model"). Puede generar jugabilidad consistente. Pero, y esta es la clave, persiste las modificaciones del usuario. Si rompes una ventana en un mundo gobernado por WHAM, el modelo recuerda eso y ajusta toda la iluminación e interacciones futuras en consecuencia. El mundo se siente vivo.

Beto

Así que ese es un enorme cambio de guiones fijos a un mundo persistente y dinámico. Y luego llevándolo al ámbito social, tenemos lo que se llama "inteligencia societaria", donde los LLMs se usan para impulsar simulacros sociales. Aquí es donde la IA empieza a modelarnos.

Alicia

Los simulacros sociales son básicamente sistemas sociales virtuales llenos de estos agentes generativos. Y dado que los agentes están impulsados por un modelo del mundo del comportamiento humano, actúan de maneras creíbles y parecidas a las humanas. Interactúan y forman comunidades que imitan el mundo real.

Beto

Por ejemplo, siempre se menciona — lo cual es un poco inquietante — AI Town.

Alicia

Es la más famosa, por seguro. AI Town tiene agentes cuyas conductas individuales, dormir, cocinar, ir a fiestas, conducen a dinámicas grupales complejas y emergentes. Cosas que los programadores nunca codificaron explícitamente. La IA no solo sabe lo que hace un humano. Modela las creencias y relaciones que impulsan ese comportamiento.

Beto

Es fascinante y sin embargo un poco inquietante ver cómo estos pueblos simulados evolucionan por sí solos. El hecho de que los modelos puedan simular cosas como la formación de jerarquías sociales o la propagación de rumores muestra un dominio bastante potente de nuestro comportamiento colectivo.

Alicia

Lo hace. Y plataformas más avanzadas como AgentSociety se están usando para estudiar fenómenos a gran escala como la polarización política o el impacto de nuevas políticas. Nos permite usar una simulación impulsada por LLM como un modelo del mundo para explorar complejos "qué pasaría si" sociales de forma segura y repetible.

Beto

Pero incluso con todo este progreso increíble, todavía hay grandes obstáculos por superar. El mayor, al parecer, es lograr que estos modelos aprendan reglas físicas robustas.

Alicia

Es el desafío definitivo al que volvemos una y otra vez. Simplemente escalar los datos y alimentar a Sora con más y más vídeos no es suficiente. Estos modelos todavía fallan en pruebas fuera de distribución. Aprenden caso por caso, no aprenden los principios primeros de la física.

Beto

Así que tenemos que ir más allá del entrenamiento puramente visual hacia enfoques híbridos. Necesitamos saber cómo funciona eso realmente.

Alicia

Lo necesitamos. Y la investigación se inclina realmente hacia lo que llaman "modelos híbridos duro + blando". La parte dura es un sistema como Genesis, que combina renderizado fotorrealista con un motor de física real integrado. El motor de física genera la salida cruda primero. La restricción blanda viene de sistemas como PhysGen, que usa un simulador de cuerpos rígidos junto a un modelo de difusión.

Beto

¿Y cómo resuelve ese tipo de modelo híbrido el problema de la causalidad que los modelos de difusión puros como Sora tienen?

Alicia

La clave está en forzar la causalidad. En un modelo como PhysGen, el simulador de física no solo proporciona datos de entrenamiento. Genera una especie de barreras digitales o máscaras de restricción que el modelo de difusión tiene que obedecer. Obliga al modelo a respetar cosas como momento o la permanencia de los objetos mientras sigue haciendo que el vídeo se vea realista. Obtienes mucho más control y puedes interpretar por qué hizo lo que hizo.

Beto

Este movimiento hacia hacer la mecánica interna más transparente parece conectarse directamente con los temas éticos y de seguridad con estos modelos.

Alicia

Oh, absolutamente. Cuando la simulación llega a este nivel, enfrentamos desafíos nuevos y serios. Primero está la privacidad de los datos. Estos WMs son entrenados en conjuntos de datos enormes y opacos de actividad del mundo real. A medida que mejoran, el riesgo de que infieran información privada sensible aumenta mucho.

Beto

Si entrenas un modelo con suficientes datos de la ciudad, podría potencialmente predecir dónde es probable que esté una persona específica en cierto momento solo a partir de unas pocas entradas pequeñas.

Alicia

Ese es el riesgo. Exacto. La falta de transparencia en cómo se recopilan y usan esos datos es un problema importante, especialmente con datos de ubicación o demográficos.

Beto

Y el segundo riesgo está ligado directamente a esa fidelidad de simulación.

Alicia

Sí, el riesgo de simular escenarios inseguros. A medida que estos modelos se vuelven increíblemente buenos simulando física, materiales y dinámicas sociales, podrían ser mal utilizados para simular actividades dañinas o ilegales. Cosas como planificación sofisticada de ataques o reconocimiento digital.

Beto

Porque reduce el coste y el riesgo de la fase de planificación.

Alicia

Precisamente. Si un actor malintencionado puede ejecutar miles de simulaciones de alta fidelidad para planear algo, reduce dramáticamente la necesidad de pruebas arriesgadas en el mundo real. Proteger el acceso a estos modelos va a volverse primordial.

Beto

Ha sido una inmersión realmente comprensiva. Hemos seguido la idea desde el concepto temprano de Craik sobre modelos mentales hasta los WMs de doble propósito de hoy. Tienes comprensión implícita de los LLMs por un lado y predicción explícita del futuro desde la simulación incorporada por el otro. Pero la misión es la misma. Entender el mundo y predecir qué sigue.

Alicia

Y esa meta última sigue siendo cerrar la brecha entre la simulación y la realidad. Sabemos que los benchmarks actuales, cosas como Physics-IQ y VBench-2.0, están intentando separar la belleza visual de la verdadera comprensión física.

Entonces, dado lo rápido que se mueven estos WMs generativos y este prometedor giro hacia modelos híbridos de física, ¿cuánto tiempo pasará hasta que podamos probar de forma fiable si una IA realmente entiende por qué algo sucede, la estructura causal, y no solo cómo se ve? ¿Y cuál será el impacto social cuando un mundo sintetizado sea física y causalmente indistinguible del real, pero todo esté funcionando dentro de una máquina?